Untertitel für Videos: Vorgaben der Barrierefreiheit und Musterlösungen

Hintergrund und Begriffsklärungen

Videos müssen auch ohne (angeschalteten) Ton verständlich sein. Davon profitieren vor allem gehörlose oder schwerhörige Menschen, aber nicht ausschließlich: Haben Sie noch nie ein Video angesehen, dessen Ton Ihre Umgebung stören würde – im Zug, im Flugzeug, in der Arbeit? Oder daheim, wenn jemand nicht mitkriegen soll, was Sie gerade ansehen? Und manchmal wünschen wir uns bei Filmen mit Til Schweiger generell Untertitel, aber das ist eine andere Geschichte.

Übrigens: Blinde Menschen benötigen – quasi als Pendant – eine Audio-Deskription oder alternativ ein Transkript, um Video-Inhalte zu erleben.

Damit Bewegtbild-Inhalte auch ohne zugehörigen Ton verständlich und „erlebbar“ sind, verlangen WCAG und BITV 2.0 Untertitel. Das sind textbasierte Versionen hörbarer Inhalte. Dazu zählt nicht nur das gesprochene Wort der Protagonisten, sondern auch Beschreibungen von Geräuschen und Musik, wenn diese inhaltlich relevant sind.

Arten von Untertiteln

Es gibt „offene Untertitel“ (gebräuchlicher ist der englische Begriff „Open Captions“) und „geschlossene Untertitel“ (auch hier gebräuchlicher: „Closed Captions“). Die Begriffe sind missverständlich, wie ich finde:

Geschlossene Untertitel bestehen aus einer mit einem Zeitstempel versehenen Textdatei. Die kann die Format-Endungen .vtt, .srt, .stl oder .xml haben – es gibt noch weitere. Diese Datei lädt man separat zum Video hoch, sodass die Zuschauer entscheiden können, ob und in welchem Format die Untertitel erscheinen.

Offene Untertitel sind immer sichtbar, denn sie werden bei der Produktion ins Bild „eingebrannt“.

Der Vorteil von geschlossenen Untertiteln ist, dass sie ein- und ausgeschaltet werden können. Zumindest bei einem Player, der solche Untertitel-Dateien unterstützt (das ist bei den gängigen der Fall). Daneben sind sie anpassbar: in Größe, Stil, Farbe etc.

Der Vorteil von offenen Untertiteln liegt allenfalls darin, dass sie unabhängig vom Player erscheinen und man sie erst gar nicht anschalten muss. Das ist gleichzeitig ein Nachteil für diejenigen, die keine Untertitel brauchen oder möchten. Wenn ein Video auf einer Konferenz gezeigt wird, sind offene Untertitel aber sinnvoll. Denn dann muss sich der Moderator nicht um den Player, die Untertitel-Dateien, das Einschalten der Untertitel usw. kümmern.

Unterschied zwischen den englischen Begriffen „Captions“ und „Subtitles“

In den USA stehen „Captions“ für Texte, die für gehörlose Menschen bestimmt sind. „Subtitles“ sind die Texte, die Fremdsprachen im Film übersetzen oder Klarstellungen (z. B. bei Genuschel) liefern.

Im Vereinigten Königreich bezieht sich der Begriff „Subtitles“ auf den Text für das gehörlose Publikum, parallel wird aber auch „Captions“ als Begriff dafür verwendet.

In Deutschland sprechen wir in beiden Fällen von Untertiteln.

Wo sind Untertitel Pflicht?

Die WCAG Level AA sowie die BITV 2.0 verlangen Untertitel für:

- Aufgezeichnete Videos mit gesprochenen Inhalten

- Live-Videos mit gesprochenen Inhalten

Umsetzung von Untertiteln in Live-Videos

Es ist gar nicht so schwer, in einer Live-Übertragung Untertitel einzubinden. In einer Software wie OBS Studio kann man eine Oberfläche für den Livestream mit verschiedenen Fenstern gestalten, eines davon können Untertitel sein. Dafür nutzt man einen Service wie Maestra, der kostenlos Live-Untertitel über Spracherkennung generiert. Dieses Browser-Fenster wird dann ein Teil der Live-Übertragung, und die Gesamt-Komposition senden Sie dann via Freigabe-Link zum Beispiel an Youtube.

Das als kleiner Exkurs, weil ich es extrem spannend finde, was sich bei der künstlichen Intelligenz gerade tut und wie viel einfacher es ist, damit Anforderungen der Barrierefreiheit zu erfüllen.

Wäre auch eine schöne Funktion für Gotomeeting oder Teams ...

Übergeordnete Anforderungen zu Untertiteln

Synchronität von Untertiteln

Untertitel müssen laut BITV-Prüfschritt 7.1.2 synchron zum Bild eingeblendet werden. Der Versatz zwischen gesprochenem Wort und Untertitel darf maximal 100 Millisekunden betragen. Sind Untertitel nicht synchron, kann das am Player oder am fehlerhaften Zeitstempel der Untertitel-Datei liegen.

Erhaltung von Untertiteln

Hier schreibt der BITV-Prüfschritt 7.1.3 vor, dass beim Download von Videos Untertitel erhalten bleiben müssen. Besitzt ein Video fest eingebrannte Untertitel, ist das zwangsweise der Fall. Lädt man in Youtube ein Video mit eingeblendeten Untertiteln (Closes Captions) vor, sind diese auch in der Download-Datei vorhanden. Diese Anforderung ist also nur insofern knifflig, als man exotische Player verwendet oder eine Datei auf der Website zum Download anbietet, die eben keine Untertitel enthält.

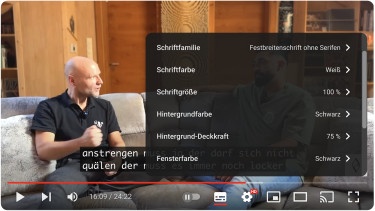

Anpassbarkeit von Untertiteln

Gemäß BITV-Prüfschritt 7.1.4 müssen Closed Captions anpassbar sein. Das liegt nahe: Die Schrift größer zu stellen oder den Kontrast zum Hintergrund zu erhöhen, dient der einfachen Wahrnehmung von Inhalten. Youtube ist hier vorbildlich und bietet zahlreiche Möglichkeiten. Ist man eingeloggt, können die vorgenommenen Einstellungen dauerhaft gespeichert werden. Das ist aber streng genommen eine reine Player-Anforderung, aber irgendwie gehört sie dazu.

Gesprochene Untertitel

Das ist die schwierigste Anforderung, die nur indirekt mit den Untertiteln zu tun hat: Nehmen wir an, Sie haben ein Video mit Ton in einer fremden Sprache in Ihren Webauftritt eingebettet; die Untertitel sind aber löblicherweise in Deutsch gehalten. Nun müssen diese deutschen Untertitel laut BITV-Prüfschritt 7.1.5 auch als Audio vorliegen. In der Praxis heißt das, fremdsprachige Videos mit einer neuen deutschen Tonspur zu versehen.

Inhaltliche Anforderungen an Untertitel

Folgende Regeln sind gemäß WCAG und BITV 2.0 verpflichtend für Untertitel:

Wortwörtliche Wiedergabe von Dialogen bzw. Sprechertexten, die auf einem Drehbuch/Skript basieren

Das bedeutet, dass auch ein gewolltes „Ähm“, „Ach“, „Uff“ in einen Untertitel gehört. Ebenso wenn eine Person bewusst stottert. Wenn es um Tutorials oder Ähnliches geht, verhält es sich anders: Da dürfen und sollten solche „Füller“ entfallen, da die Texte dann deutlich einfacher zu lesen sind. Auch Vereinfachungen sind gestattet – das steht in den Regeln zwar nicht explizit, aber ich meine, damit trägt man zur Verständlichkeit bei. Ein Beispiel ist die Aufteilung eines verschachtelten Satzes auf mehrere oder die grammatikalische Korrektur von Fehlern– sofern sie nicht explizit gewünscht ist.

Identifikation der sprechenden Person

Das wird in der Praxis (man sehe sich mal einige Filme in der ARD- oder ZDF-Mediathek an) meist nicht umgesetzt. Dafür behilft man sich mit unterschiedlichen Text-Farben für unterschiedliche Protagonisten. Auch nicht wirklich barrierefrei – Stichwort Farben-Blindheit. Das Ideal gemäß Barrierefreiheit ist der Hinweis auf die Person, bevor die wörtliche Rede erscheint:

(Peter) Was soll das?

In der Praxis wird das kaum gemacht, ich bin auch nicht sicher, ob uns das so viel weiterhilft. Ein Kompromiss ist es, nur Namen von denjenigen einzublenden, die im Bild nicht eindeutig identifizierbar sind.

Textliche Wiedergabe von Stimmen aus dem Off

Alles, was außerhalb des aktuellen Bild-Fokus gesprochen wird, muss ebenfalls in den Untertiteln vorkommen: Eine Stimme aus einem anderen Raum oder von draußen; oder der nicht genau identifizierbare Ruf aus der Menge. Wenn die rufende Person nicht wichtig und nicht namentlich bekannt ist, könnte das so aussehen:

(Ruf eines Mannes aus der Menge) Das ist doch Schwachsinn!

Hinweise auf die Aussprache

Für die Dramaturgie eines Videos ist die Art und Weise, wie Wörter ausgesprochen werden, relevant. Wenn eine Person flüstert, muss dies in den Untertiteln kommuniziert werden, ebenso wenn eine Person singt:

(Flüsternd) Das tut mir leid.

(Manni singt) Ich geh’ mit meiner Laterne ...

Die Wörter in Klammern werden oft groß geschrieben. Ob das die einzig richtige Variante ist? Ich sage mal „nein“.

Beschreibung von wichtigen Hintergrund-Geräuschen oder Hintergrund-Musik

Ein reines Hintergrund-Gedudel in einem Tutorial ist nicht erwähnenswert. Eine gezielt eingesetzte, Spannung aufbauende Musik-Sequenz oder ganz bewusst eingesetzte Stille dagegen schon. Auch hier ist die Großschreibung gängig:

(DRAMATISCHE MUSIK)

(SCHWEIGEN)

Ein Song, dessen Text nicht inhaltlich relevant ist, aber der der Allgemeinheit geläufig ist, muss mit Name und Interpret benannt werden:

(MUSIK) „Angel of Death“ von Slayer

Bei Hintergrund-Geräuschen ist es ähnlich:

(TOSENDES MEER)

(LAUTES KINDER-GESCHREI)

Wiedergabe inhaltlich relevanter Text-Passagen aus Liedern

Sofern ein Liedtext explizit zu einer Szene gehört, muss er erscheinen. Ein englischer Liedtext muss dabei nicht zwingend übersetzt werden – das ist er meist schon als fest eingebrannter Untertitel im Video.

Beispiel: Lucky Luke reitet in den Sonnenuntergang, und im Untertitel steht zurecht:

♫ Einsamer Cowboy, bist so weit, weit von zu Haus ♫

Zumindest, wenn es eine Deutsche Fassung mit Freddy Quinn ist. Sind die Notenzeichen Vorschrift? Nein, man könnte das auch so rüberbringen:

(SONG-TEXT) „Einsamer Cowbow, bist so weit, weit von zu Haus“

Grafische, orthografische Vorgaben und Empfehlungen für Untertitel

Pflicht

- Keine Spoiler: nicht über ein Ereignis per Untertitel informieren, das visuell erst zu einem späteren Zeitpunkt eintritt

- Kontrastverhältnis von 3 : 1 zum Hintergrund einhalten (in der Standard-Einstellung ohne Anpassungen durch die Betrachter).

- Farben nicht als alleiniges Mittel einsetzen, um eine bestimmte Bedeutung zu vermitteln.

Empfehlungen

- Untertitel ausreichend lange einblenden, eine grobe Maßgabe sind 0,3 Sekunden pro Wort.

- Eine oder zwei Zeilen auf einmal einblenden, maximal drei in Ausnahmen.

- Keine gefettete Schrift (Bold-Schnitt) verwenden.

- Texte an sinnvollen Stellen umbrechen lassen (Kommas bieten sich an) und lange Zeilen vermeiden: maximal 32 Zeichen.

- Keine Großbuchstaben in „normalen“ Texten verwenden.

- Wörter, die betont werden, kursiv setzen (nicht als Großbuchstaben).

- Laut gesprochene Sätze mit Ausrufezeichen versehen, aber nicht gleich mit mehreren (dann lieber in Klammern auf die Lautstärke hinweisen)

- Wichtige Bild-Bereiche nicht überdecken.

- Korrekte Zeichensetzung anwenden.

- Bei Pausen zwischen den Einblendungen mindestens 1,5 Sekunden einhalten, ansonsten Untertitel direkt aufeinander folgen lassen (z. B. 25 Millisekunden Abstand als Default bei Happyscribe).

- Untertitel länger stehen lassen, wenn schwere Wörter vorkommen, oder wenn viel Bewegung im Bild ist; trotzdem Synchronität wahren, siehe oben.

Automatische Erstellung von Untertiteln mit künstlicher Intelligenz

Untertitel manuell einzugeben, ist eine sehr zeitraubende Angelegenheit. Umso schöner, dass sich die Spracherkennung via künstlicher Intelligenz in den letzten Jahren stark weiterentwickelt hat. Die Ergebnisse können sich sehen lassen, und auch preislich sind die Angebote solcher Plattformen attraktiv. Es sei denn, man möchte oder muss die Anforderungen der Barrierefreiheit erfüllen.

Die Vorgaben von WCAG bzw. BITV 2.0 sind streng, wie beschrieben. Deshalb ist es zwingend erforderlich, dass die automatisch generierten Texte manuell überarbeitet werden. Nur dann ist sichergestellt,

- dass es sich um eine Eins-zu-eins-Wiedergabe des Gesagten handelt,

- dass die Synchronität gewahrt bleibt und

- dass die Untertitel das Bild nicht überfrachten.

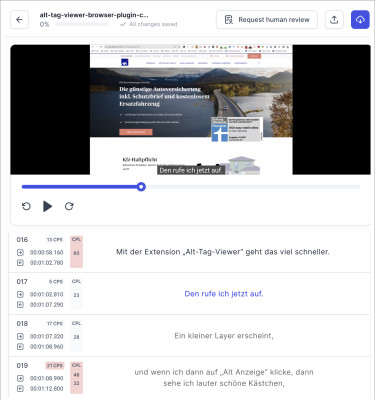

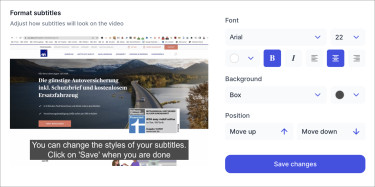

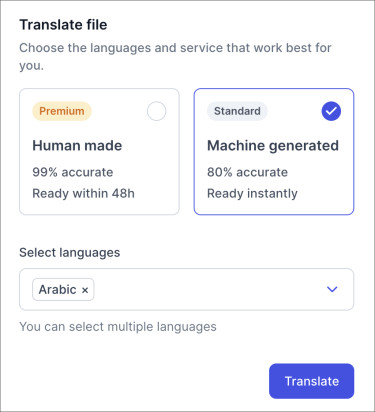

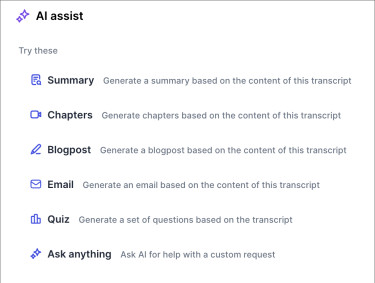

Im Folgenden zeige ich einige sehr hilfreiche Features zur Erstellung von Untertiteln am Beispiel von Happyscribe. Vorab sei erwähnt, dass es noch andere vergleichbare Angebote gibt, als da wären:

In Youtube werden im Übrigen Untertitel in der erkannten Sprache automatisch erzeugt. Die Qualität steigt stetig, aber es ist noch ein weiter Weg bis zur automatischen Barrierefreiheit

Fazit

Es gibt viele Plattformen und Werkzeuge, die uns sehr gut dabei unterstützen, Untertitel für (Live-)Videos in barrierefreier Form bereitzustellen. Ein manuelles Feintuning ist zwingend erforderlich und immer noch mit Zeitaufwand verbunden. Digitale Barrierefreiheit läuft nicht nebenher, wenn man es ernst mit ihr meint – das haben wir schon bei den „Overlay-Tools für Barrierefreiheit“ festgestellt.

Nutzen Sie die aktuellen Möglichkeiten der KI, um deutlich schneller als früher hochwertige Ergebnisse zu erzielen und Ihre Video-Inhalte auch ohne (wahrnehmbaren) Ton vollständig erlebbar zu machen.

Kontaktieren Sie mich: